人工智能作为一项颠覆性技术,在为人类社会带来发展机遇的同时,也带来了不可预测的风险,人类面临道德、隐私和安全等方面的问题与挑战。国际标准化组织(ISO)和国际电工委员会(IEC)于近日制定发布了 ISO/IEC 42001 人工智能管理标准。该标准提供了一个可认证的人工智能管理体系(AIMS)框架,在此框架内,人工智能体系作为人工智能保证生态系统的一部分进行开发和部署。

ISO/IEC 42001 采用类似于ISO 9001质量管理体系标准和ISO/IEC 27001信息安全管理体系标准的方法,提供了管理风险和操作方面的[敏感词]实践、规则、定义和指导。包括如下几个部分内容:

1.适用范围;

2. 援引规范;

3.术语和定义;

4.组织环境;

5.领导力;

6.策划;

7.支持;

8.运行;

9. 绩效评估;

10. 改进;

附录A 控制目标和控制措施

附录B 控制措施实施指南

附录C 与人工智能有关的组织目标和风险源

附录D 人工智能管理体系的跨行业应用

一、ISO42001人工智能管理体系标准正文部分重点内容介绍

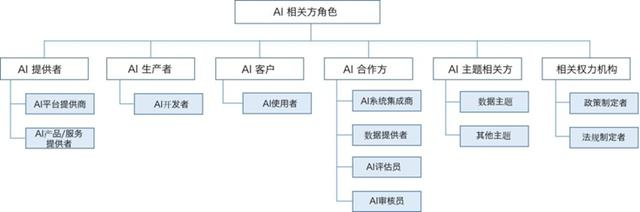

(1)确定组织在人工智能领域的角色定位

在建立人工智能管理体系时,组织首先应就自身在人工智能系统领域的角色进行定位,建立和实施人工智能管理体系的内容。下图诠释了人工智能系统各相关方角色,供组织在确定自身角色定位时参考。

(2)理解组织面临的内外部问题

确定角色定位后,组织应进一步分析在人工智能管理领域所面临的内外部问题,从而为建立人工智能管理体系提供必要的输入。

(3)理解组织利益相关方需求与期望

组织应识别与人工智能管理的利益相关方,理解各相关方针对人工智能系统的管理需求与期望。如组织是人工智能平台提供商,则需要考虑人工智能平台用户、人工智能平台合作方、人工智能合规监管者的需求与期望,这些需求与期望可能包括个人隐私保护、事件处理的透明性、合规管理等等。

(4)制定人工智能管理方针

与所有其他管理体系标准一样,组织在建立人工智能管理体系时,其[敏感词]管理者应制定人工智能领域的管理方针,典型的人工智能管理方针可考虑包含:

目标和原则、数据管理、系统设计、透明性和可解释性、道德和法律合规、培训和教育、监督和评估。

(5)进行人工智能风险评估,对人工智能系统可能产生的影响进行评价

组织应对人工智能风险进行识别、分析与评价。制定人工智能风险评估流程,明确人工智能风险准则,并按照风险评估流程与准则开展人工智能风险评估工作。组织针对不可接受的风险应参照标附录A选择风险控制措施,制定详细的风险处置计划,按照控制措施选择结果制定《人工智能管理体系适用性声明书》。人工智能风险评估的具体方法可参考国际标准化组织于2023年初发布的一份标准《ISO/IEC23984:2023 信息技术 - 人工智能 - 风险管理指南》的内容。

(6)人工智能目标管理

组织策划人工智能管理体系过程时需要基于内外部环境分析、相关方需求及期望以及风险评估结果制定管理目标,明确实现管理目标的措施、责任及时间表。

(7)人工智能管理体系标准“支持”条款

该标准还明确了为支持管理体系有效运行的支持要求(或者说是赋能要求),包括:资源、能力、意识、沟通及文件化信息。

(8)人工智能管理体系运行

人工智能管理体系运行部分的要求与ISO27001:2022信息安全管理体系标准几乎相同,人工智能管理体系运行取决于风险评估结果及风险处置要求,而风险处置措施的执行就是体系运行的要求,风险处置的内容实际是附录A控制措施的内容。

(9)人工智能管理体系绩效评估与持续改进

人工智能管理体系绩效评估与持续改进部分的要求与ISO27001:2022信息安全管理体系标准相同,标准明确规定对管理体系绩效进行持续监视、测量与评价,对管理体系执行的有效性进行定期的内部审核,高层管理定期对管理体系适宜性、有效性及充分性进行评审,对体系运行、绩效评估、内审、管理评审等过程的各类不符合采取纠正及纠正措施,从而持续改进人工智能管理体系的适宜性、充分性和有效性。

二、ISO42001人工智能管理体系标准控制措施介绍

ISO42001人工智能管理体系标准“附录A”明确规定了企业在人工智能系统设计与运行过程中需要执行的控制目标与控制措施,各项控制措施的应用取决于人工智能系统的风险评估结果。

ISO42001人工智能系统控制目标与控制措施:九大控制域:

1、人工智能方针(政策)

2、内部组织管理

3、人工智能系统资源

4、人工智能系统影响评估

5、人工智能系统生命周期

6、人工智能系统数据

7、人工智能系统相关方需了解的信息

8、人工智能系统的使用

9、第三方关系

1、人工智能方针(政策)

标准规定组织应制定人工智能方针,确保人工智能方针与组织其他管理领域的方针(例如质量方针、信息安全方针、健康与安全方针及个人隐私保护方针等)保持一致,并对方针进行定期评审。

2、内部组织管理

在组织内建立问责制,明确规定人工智能系统运行与管理的各项职责。

需要考虑采取以下控制措施:

根据自身需求定义人工智能的角色与职责(这些角色与职责可能包括人工智能风险评估、个人隐私保护、健康与安全、供应链管理等),并将这些角色与职责分配至相关职能。

在明确角色与职责的基础上,组织应建立有效的报告流程以确保雇员及时报告人工智能生命周期的关注事项,这些关注事项涉及人工智能生命周期的各个阶段。这里的关注事项一般指人工智能的安全漏洞、人工智能系统可能带来的伦理问题等等。

3、人工智能系统资源

组织应对人工智能所需的各项资源进行详细描述以便充分理解和解决人工智能面临的风险与影响。需要针对人工智能系统各类资源进行控制,这些资源包括:人工智能系统部件、人工智能系统全生命周期涉及的数据、人工智能开发应用工具、系统与计算资源、人力资源及所需的技能。不仅需要对这些资源进行配备,更需要对这些资源进行全面识别、形成文件并随着人工智能系统的变化进行动态变更。

4、人工智能系统(负面)影响评估

组织应在人工智能系统生命周期对利益相关方可能造成的(负面)影响进行评估。需要建立人工智能系统(负面)影响评估过程,明确人工智能系统影响评估的职能、评估的时机、评估应考虑的内容等。按照所建立的过程要求对人工智能系统在其生命周期各阶段对个人、群体及社会可能造成的(负面)影响进行评估,并将评估结果形成正式的文件。

5、人工智能系统生命周期

确保组织针对人工智能系统的设计与开发识别和制定文件化的管理目标,并落实执行各项管控过程。

1)负责任地开发人工智能系统:确定管理目标并形成文件,用以指导开发可靠的(trustworthy)人工智能系统。标准提到的“可靠性(trustworthy)”是指“人工智能系统能够在没有偏见或歧视的情况下,以可预测和可靠的方式做出正确的决策”。

2)定义人工智能系统的设计与开发过程:为确保组织设计与开发的人工智能系统具备可靠性特征,组织需要定义人工智能系统设计与开发的各个具体过程,并将这些过程文件化。

3)明确人工智能系统的需求与规格:针对新的人工智能系统或对现有人工智能系统的材质增强(material enhancements),需要明确设计与开发需求及规格。

4)确保人工智能系统的设计与开发过程形成文件:人工智能系统的开发与设计过程需要形成文件,文件化的目的是确保证实开发与设计过程符合组织目标设计开发需求、规格及准则。

5)对人工智能系统进行验证和确认:对人工智能系统的验证和确认措施需要进行定义并形成文件,验证和确认措施的使用准则也需要进行规定。

6)对人工智能系统的部署进行管控:需要制定人工智能系统部署计划,确保在正式部署前相关的要求得到满足。

7)对人工智能系统的运行和监视进行控制:为确保人工智能系统持续有效地运行,组织需要定义必要的管控要素,并将这些管控要素形成文件。这些管控要求至少应考虑系统和运行表现监视、修复、更新及支持。

8)确定所需的人工智能系统技术文件:针对不同类别的利益相关方,组织要确定他们所需的人工智能系统技术文件,并以适宜的形式向他们提供这些文件。

9)对人工智能系统的事态日志进行记录:人工智能系统在运行过程中,在需要时应启用自动保留事件日志的功能。

6、人工智能系统数据

确保组织充分理解数据在人工智能系统生命周期各阶段的作用与影响。

1)管理人工智能系统开发及优化的数据:定义人工智能系统开发的数据管理过程,将其文件化并予以执行。

2)数据获取控制:针对人工智能系统使用的数据,组织应针对这些数据的获取/选用的详细信息进行确定并形成文件。

3)人工智能系统数据质量控制:针对人工智能系统开发与运行所使用的数据,组织需要明确规定这些数据的质量要求,以确保数据满足规定的要求。

4)数据来源控制:针对人工智能系统所使用的数据,组织应就数据来源的验证及记录过程进行定义,并将这一过程形成文件。

5)数据准备管理:组织应对数据准备需求及方法进行定义,并形成文件。

7、为人工智能系统相关方提供信息

确保组织利益相关方能够获取必要的信息以理解并评估风险及影响。

1)准备适用于用户的系统文件及信息:组织应确定并向人工智能系统用户提供所需的信息。

2)确保信息的可理解性:组织向相关方提供的信息应清晰、可理解并适用于他们。

3) 提供外部报告机制:组织应确保相关方能够报告人工智能系统产生的负面影响。

4)沟通事件:组织应制定人工智能系统事件沟通计划,明确向用户沟通事件的时机及方式,并将其文件化。

5)向相关方提供信息:组织应明确向相关方报告人工智能系统信息的义务,并将其文件化。

8、人工智能系统使用

确保组织负责任地根据组织方针使用人工智能。

1)建立过程,确保负责任地使用人工智能。

2)制定负责任地使用人工智能的目标。

3)确保人工智能按照预期用途进行使用。

9、第三方关系

对于人工智能系统生命周期中涉及的第三方,组织应理解其责任并始终对这些责任负责。组织在评估并降低第三方风险的同时,也应要求第三方评估并处置其与人工智能产品和服务相关的风险。

文章来源于网络